IEEE Spectrum报告!数据中心液冷技术路线图

来源 | IEEE Spectrum

先进 AI 芯片正在数据中心中产生越来越高的热负载,迫切需要更先进的冷却解决方案。液冷正逐步成为传统风冷系统的可行替代方案。目前提出的主要液冷技术路线包括:通过冷板循环水冷却、通过冷板循环沸腾液体冷却、整机浸没液体冷却,以及整机浸没沸腾液体冷却。

00

背景介绍

走进一座典型的数据中心,首先映入眼帘的往往是噪音——成千上万个风扇发出的低沉嗡鸣声:芯片旁的风扇、机柜背板的风扇、交换机上的风扇。这些风扇不断将芯片产生的热空气推向空调系统,以维持对温度高度敏感的计算芯片运行。然而,这套体系正在逐渐失效。过去十年,最先进计算芯片的功率密度呈爆炸式增长。2017 年,英伟达推出 V100 GPU,功耗为 300 W,其中大部分最终以热量形式散出;2020 年 A100 的功耗提升至 400 W;2022 年发布的 H100 已高达 700 W;而 2024 年公布的 Blackwell 架构 GPU,单颗功耗已达到 1,200 W。

“在未来一到两年,芯片路线图已指向 2,000 W 以上,”液冷公司 Mikros Technologies 总裁兼 CEO Drew Matter 表示,“事实上,整个行业已在为 5 kW 乃至更高功耗的芯片做准备。”这场功率爆炸的直接推手正是 AI。越来越密集、复杂的计算负载使芯片产生的热量已达到难以管理的程度。

Accelsius CEO Josh Claman 指出:“过去一个机柜的平均功率密度大约为 8 kW,而面向 AI 的机柜正增长到 100 kW,这是数量级上的跃迁。正是 AI 的普及让我们迫切需要找到新的数据中心冷却方式。”

这意味着行业必须从风冷转向液冷。例如,水的比热约为空气的 4 倍,密度约为空气的 800 倍,因此单位体积的吸热能力约为空气的 3,200 倍;同时水的导热系数约为空气的 23.5 倍,使其能更高效地传递热量。

Airedale by Modine 浸没冷却总经理 Seamus Egan 形象地表示:“你把手伸进热烤箱里通常不会被灼伤,但把手伸进沸水里会立刻产生三度烫伤,因为液体传热速度快得多。”

目前数据中心行业基本已达成共识:至少在 AI 型数据中心中,液冷将成为主流解决方案。但液冷并非只有一种方式,从相对成熟到较为激进,共存在四条主要技术路径。

01

单相直触芯片液冷(Single-Phase Direct-to-Chip Cooling)

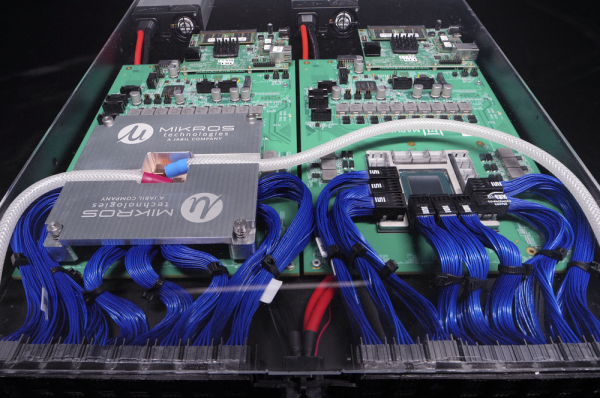

目前技术成熟度最高的液冷方案是以水为冷却介质的直触芯片液冷。事实上,许多 AI 数据中心已经在其发热最集中的芯片上部署了这种直触式液冷系统。在该架构中,一种称为“冷板(Cold Plate)”的金属模块被直接安装在芯片表面。冷板内部集成有供冷却液流动的微通道,其尺寸与芯片封装匹配并安装在服务器内部。冷却介质通常为水,并添加一定比例的乙二醇,以抑制细菌滋生、稳定工作温度、防止冻结与腐蚀,同时提高液体黏度。乙二醇-水混合液在压力驱动下流经冷板,从热源处直接带走热量。

Companies like Mikros Technologies are pursuing single-phase direct-to-chip liquid cooling. In this technique, a cold plate is placed on top of the hottest chips. Liquid is circulated through the cold plate, whisking away heat. Marvell Technology

在系统层面,该乙二醇水通常运行在一个封闭回路中,从冷板流向换热器,在换热器中被冷却后再回流至冷板。换热器内部另设一套独立的“机房水(Facility Water)”回路,用于为乙二醇水降温;机房水则通过两种方式进行冷却:其一是冷水机组(电驱动制冷设备),其二是干式冷却器(通过风扇将环境空气吹过管路进行散热的室外换热设备)。相较冷水机组,干式冷却器结构更简单、能效更高,但仅适用于气候较冷的地区,因为其无法将水温降至低于环境温度。

该方案的一个现实限制在于:不可能为服务器内所有发热部件都安装冷板。实践中仅对功率密度最高的器件——主要是 GPU 以及部分 CPU——实施直触液冷,而电源模块、内存等中低功耗部件仍沿用传统风冷方式。

Nortek Data Center Cooling 总裁 Karin Overstreet 指出:“行业正逐步转向混合冷却架构。液冷将承担机房或数据厅约 80% 的散热负载,其余约 20% 仍由现有的风冷系统完成。”

02

两相直触芯片液冷(Two-Phase Direct-to-Chip Cooling)

随着 GPU 功率密度持续攀升且毫无放缓迹象,单相直触水冷正在逼近其物理极限。理论上可以通过提高水流量来增强散热能力,但这将显著增加能耗;或者提高芯片的工作温度,但这不仅会影响性能,还会在长期内加速器件老化。所幸,物理学提供了第三种途径——进一步挖掘传热过程中的“相变潜热”。所谓潜热,是指物质在发生相变(本例中为液态转为气态)时所吸收的能量。在 GPU 表面发生沸腾时,冷却液在不显著升高温度的情况下,通过气化过程吸收额外的潜热,从而显著提升单位面积的散热能力。

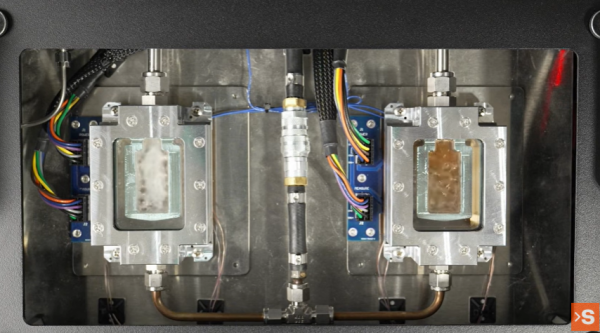

Companies like Accelsius are proposing two-phase direct-to-chip liquid cooling. Here, a cold plate is also placed on top of the hottest chips, and the liquid circulating through the cold plate boils directly atop the chip. Big Idea Productions

两相直触芯片液冷的基本工作方式即基于此原理。该方案采用专门配制的介电型冷却液,在冷板内部循环,并在高功率芯片表面直接发生沸腾,形成蒸汽;蒸汽随后被引导至换热器,并通过机房水回路进行冷凝与降温。ZutaCore 首席技术官 My Truong 将这一过程概括为:“本质上是用‘沸腾’来实现冷却。”

由于水在常压下的沸点为 100 °C,远高于芯片可接受的工作温度,因此该技术采用低沸点的专用流体。ZutaCore 首席布道官 Shahar Belkin 表示,其所使用的流体来自 Honeywell、Chemours 等化工厂商,最低沸点可低至约 18 °C,且可通过调节回路压力精确控制。该流体为介电材料,即在无外加电场极化条件下不导电,因此即便发生泄漏,也不会像水一样损伤昂贵的电子设备。

在单相水冷体系中,冷却水在流经高温芯片时温度会迅速升高,因此必须保持较低的进水温度,在大多数气候条件下都需要冷水机组参与制冷。而在两相沸腾介电液体系中,冷却液的温度基本保持恒定,仅发生相态变化,因此机房水与循环液均可维持在更高温度区间运行,从而带来显著的能耗节省。

Accelsius 产品市场总监 Lucas Beran 指出:“由于冷板上的沸腾过程效率极高,我们可以接受比单相系统高出 6–8 °C 的机房水温度。”此外,两相直触芯片液冷所需的循环流量显著低于传统单相水冷。Belkin 表示,其流量约为单相水冷的五分之一,因此泵送能耗更低,系统对设备的机械应力和潜在损伤风险也更小。

他进一步指出,对于功率约 2,000 W 的高端芯片,单相水冷“需要以每分钟约一加仑的流量将水泵入冷板,这意味着极高的压力和流量,泵送成本高昂,并且过高流速还可能对系统本身造成损伤”。

03

单相浸没液冷(Single-Phase Immersion Cooling)

直触芯片液冷虽然相比单纯风冷具备更强的散热能力,但其本质仍依赖冷板作为中间传热界面。如果完全绕过冷板,将整台服务器直接“浸入”冷却液中,会发生什么?目前已有企业在实践这种方案。在该架构下,数据中心不再以传统机柜为核心,而是围绕“浸没槽(Immersion Tank)”进行布局,每个槽体大小大致相当于一台立式冰箱。浸没槽内充满介电型冷却液,通常为油类流体,需具备非导电性、良好的导热性能,同时还要求长期化学稳定性以及较低的环境与火灾风险。Baltimore Aircoil 浸没冷却全球销售经理 Rachel Bielstein 表示,上述特性是浸没冷却介质的基本门槛。

Sustainable Metal Cloud is advocating for single-phase immersion cooling, in which an entire server is submerged in a vat of liquid to keep it cool.Firmus Technologies

在浸没冷却体系中,服务器内所有部件均由同一种液体进行冷却。冷却液吸收热量后,再通过不同方式将热量导出。以 Baltimore Aircoil 为例,其设计了一种集成式换热结构,在槽体内部布置盘管与换热板,让机房水在其中循环带走热量。被加热的机房水随后被泵送至室外冷却器,将热量释放至空气中并降温,再返回槽体内继续换热。Bielstein 指出,相比传统方案,该流程可节省最高达 51% 的能耗。

总部位于新加坡的 Sustainable Metal Cloud(SMC)为数据中心提供浸没冷却系统,并已系统性梳理了服务器在该方案下所需的结构与材料改造。除去内置风扇外,SMC 还会更换芯片与散热器之间的部分热界面材料(TIM),因为某些常规材料在油性介质中会发生性能劣化。SMC 及其姊妹公司 Firmus 的联合 CEO Oliver Curtis 表示,这些改动虽小,却对系统稳定运行至关重要。

Curtis 强调:“我们为计算机创造了一个几乎完美的运行环境——没有灰尘、没有气流、没有振动,因为不再需要风扇,而且温度始终保持在最优区间。”然而,部分先进芯片的功率密度仍高到仅靠低流速油性液体难以完全散热。在这种情况下,需要为这些芯片额外配置冷板,以强化油液在其表面的流动换热能力。

Airedale by Modine 的 Egan 指出:“单相浸没在应对这些先进芯片时已经触及极限。引入冷板虽然能为更先进的芯片架构提供支持并降低单相介电液的热负载,但新的挑战随之而来——系统将不得不同时维护两套独立的冷却回路。”

04

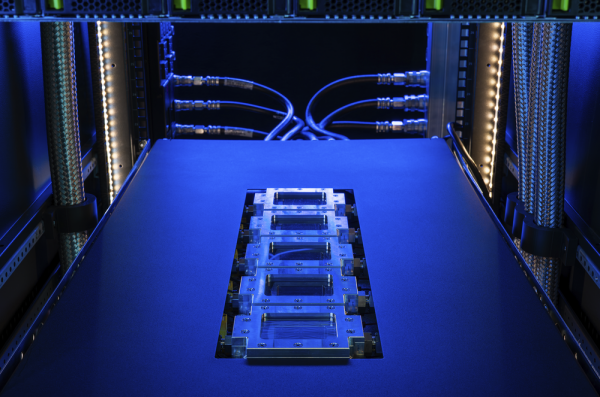

两相浸没液冷(Two-Phase Immersion Cooling)

如果任何一种单一冷却方式都难以独立应对未来芯片的热负载,那么不妨将这些技术“合而为一”——把整个数据中心“浸入一槽沸腾的液体”之中。事实上,已有企业开始这样做。Accelsius 的 Beran 形容,两相浸没是当前数据中心液冷领域“最具登月式突破意味的技术路线”。

而 Chemours 数据中心液冷全球市场经理 Brandon Marshall 则认为,这正是行业未来的发展方向:“根据我们的研究,两相浸没将以一种相当合理、可规模化的方式逐步走向主流。”

在 Chemours 位于美国特拉华州纽瓦克的实验室中,研究团队正在开发专用的两相浸没冷却液。该方案将整台服务器浸入专用介电流体中,液体在高温部件表面直接沸腾,借助相变潜热实现超高效率散热。

Marshall 指出,相较单相液体,两相(沸腾)液体凭借潜热效应具备 10–100 倍的冷却能力。而即便两相直触芯片方案可满足当前 GPU/CPU 的需求,内存模组、电源模块等部件仍需风冷。随着芯片功率持续上升,这些“非核心芯片”同样将逐步被纳入液冷体系。

“这些问题不会消失,”Marshall 表示,“随着行业演进,人们将越来越习惯于在机柜内使用两相流体,就像如今已接受单相直触芯片水冷一样。”

Chemours 的两相浸没系统采用非导电、非腐蚀性的专用冷却液,按芯片理想工作温度设计沸点。液体在芯片表面沸腾生成蒸汽,蒸汽在槽体顶部或背板处的冷凝器上冷凝回流。该冷凝器仅需温度比沸点低约 6 °C(约 43 °C)的机房水即可工作,从而在多数气候区无需冷水机组,显著简化基础设施。

Chemours 的案例研究显示,两相浸没在多数气候区的长期综合成本优于单相浸没及单相直触芯片方案。例如在美国弗吉尼亚州 Ashburn 区域,10 年总拥有成本(TCO)分别为:

·单相直触芯片:4.36 亿美元

·单相浸没:4.91 亿美元

·两相浸没:4.33 亿美元

其优势主要来源于更低的电力需求和更简化的机械系统。

当然,该方案亦面临维护挑战。批评者认为,两相浸没使用的流体高度专用、价格昂贵且易挥发,使运维复杂化。Beran 形象地指出:“当你打开浸没槽,看到‘美元在蒸发’,维护就变得颇具挑战。”对此,Airedale by Modine 的 Egan 表示,其 EdgeBox 浸没槽通过结构设计使蒸汽层保持在槽体下部,上方保留空气层,在短时间开启槽体维护时蒸汽不易逸散,从而将流体损耗控制在极低水平。