谷歌出手 47.5亿 美元!从液冷TPU 到能源全面布局

[洞见热管理]获悉,Alphabet 宣布已达成最终协议,将以 47.5 亿美元现金(并承担相关债务)收购数据中心与能源基础设施解决方案提供商 Intersect。该交易预计于2026年上半年完成。

Alphabet表示,Intersect在交易完成后将继续保持独立运营,并由其创始人兼首席执行官Sheldon Kimber继续领导,此次收购将有助于Alphabet更快地投建新的数据中心及电力设施。

表面看这是一笔围绕能源与基础设施的并购;但在 AI 算力需求持续攀升、数据中心功率密度快速跃迁的背景下,其更深层意义,正在于为下一代高算力数据中心提前布局电力与基础设施能力。

01

算力瓶颈正在外移:从芯片性能到“电与热”约束

随着AI模型规模与推理负载持续攀升,制约算力扩张的核心因素,正在从单纯的芯片性能,外移至数据中心层面的供电能力与散热边界。对于超大规模云厂商而言,是否能够稳定承载不断抬升的功率密度,已成为决定 AI 基础设施扩展节奏的关键变量。

当前主流 AI 服务器单机功耗已进入千瓦级区间,面向大规模训练与推理集群,单机柜功率密度正快速迈向百千瓦级。在这一功率水平下,传统风冷在效率、能耗与系统稳定性方面的物理极限日益显现,散热能力开始直接制约算力部署密度与数据中心选址灵活性。

热管理不再只是服务器层面的工程问题,而是与供电系统、园区规划及整体基础设施深度耦合的系统能力。这也使得云厂商在推进 AI 芯片与算力平台演进的同时,必须同步前置布局电力、冷却与基础设施资源,以确保高算力集群能够持续、可预期地扩展。

02

TPU算力平台演进,高密度部署对热管理提出更高要求

作为全球少数具备自研 AI 芯片、自建数据中心并深度优化系统架构能力的云厂商之一,Google 在 AI 算力布局上始终采取高度垂直整合的路线。其中,开发的ASCI TPU(Tensor Processing Unit)已成为其支撑大规模模型训练与推理的核心算力平台。

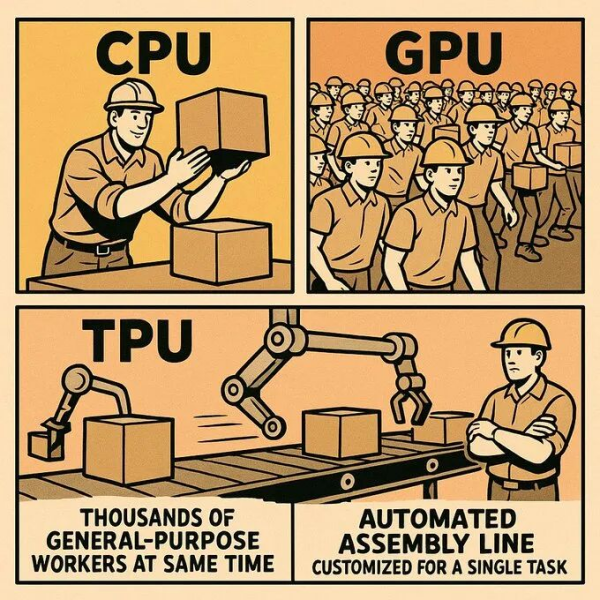

在理解Google TPU对散热与基础设施提出的更高要求之前,有必要先区分当前数据中心中三类核心算力芯片——CPU、GPU 与 TPU在架构与负载形态上的本质差异。传统 CPU 以通用计算为核心,强调低延迟与复杂指令处理能力,单芯片功耗相对可控,长期以来主要依赖风冷即可满足数据中心需求。

GPU 则通过大规模并行计算架构,显著提升了 AI 训练与推理效率,但其功耗与热密度也随算力跃升快速攀升,成为率先推动液冷导入的核心器件之一。

相比之下,TPU 属于面向 AI 负载高度定制的专用加速器,在计算单元、存储与互联结构上均围绕矩阵运算与持续高负载场景进行优化。这种设计使 TPU 在特定模型训练中具备更高的能效比,但也意味着其在集群化部署时呈现出功耗集中、热释放高度稳定且持续的运行特征,对供电与散热系统提出了更高一致性与可靠性要求。

随着 TPU 代际持续演进,其算力密度与系统集成度不断提升。相比通用 GPU 架构,TPU 更强调在特定AI负载下的计算效率与互联带宽,这也使其在大规模集群部署时,呈现出高并行度、高稳定负载、功耗集中度高 的典型特征。在TPU Pod等集群形态中,大量算力节点以高度一致的工作状态持续运行,对供电与散热系统的稳定性提出了更高要求。

在模型训练规模不断放大的背景下,TPU 单节点及系统级功耗亦随之抬升。高算力密度与持续满载运行,使 TPU 集群在部署层面更早触及传统风冷架构的效率边界,也进一步放大了热管理在系统设计中的权重。

03

从 TPU 到液冷:Google 的系统级热管理架构

随着 AI 模型算力需求快速跃升,Google在TPU 集群的液冷部署上走在全球前列,形成了端到端、系统级的热管理解决方案。Google 早期即在 TPU 服务器中引入冷板式液冷方案,对核心发热器件进行定向散热,并通过优化液路设计与回水温管理,实现高负载下的稳定运行。相较传统风冷,液冷在高热流密度场景中具备更高的传热效率,使 TPU Pod 能够在更高功率密度下持续运行,同时显著降低制冷系统能耗。

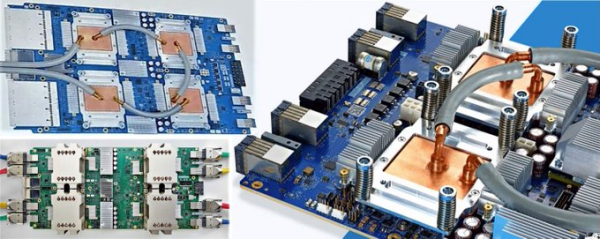

从TPUv3开始,Google 就在量产 AI 服务器上引入直接液冷:冷板采用铜材质微通道鳍片结构,并设计了“中心冲击、双向分流(split-flow)”流道,显著降低热阻,提升芯片 TDP 支持与运行频率,使单位体积算力密度提升 1.6 倍以上。

TPUv4 更进一步,首次采用裸芯封装与并联液冷流道,配合主动流量控制阀,实现不同芯片间的精确流量与温度分配,液冷系统从传统散热演进为可控、可调的高性能热管理系统,直接适应 AI 训练过程中功耗波动大、负载变化快的特点。此后,TPUv5p 与 Ironwood(TPUv7)均采用冷板式液冷,每颗 Ironwood TPU 功耗突破 600W,每个机架功率可达数MW,支持大规模、高密度的 AI 推理与训练工作负载。

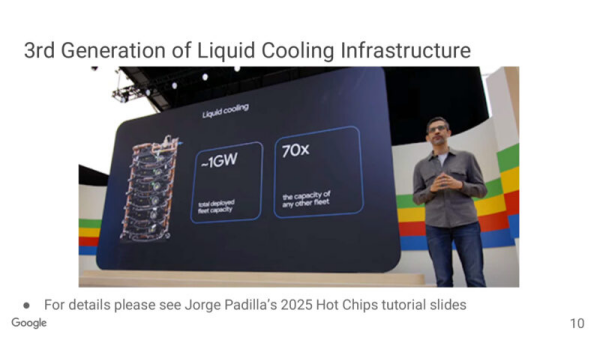

2024年的Google I/O 开发者大会上,谷歌CEO桑达尔·皮查伊透露,谷歌的液冷设备数量已增长至约1吉瓦。谷歌的第七代 TPU Ironwood 性能比肩英伟达的B200,功耗单芯片突破600w,集群功率高达10MW。目前已经确认采用冷板式液冷技术。Ironwood芯片托盘。每个托盘包含4个Ironwood TPU芯片,该托盘采用液冷散热。

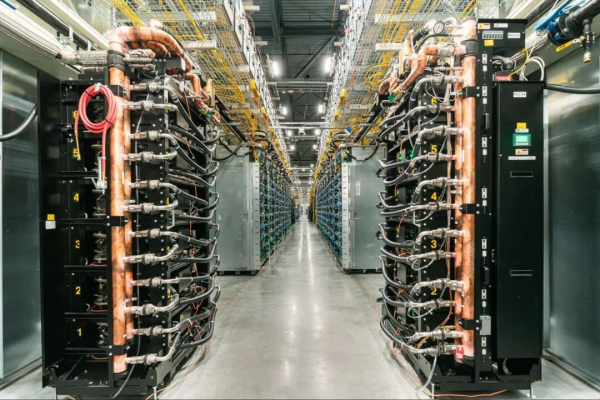

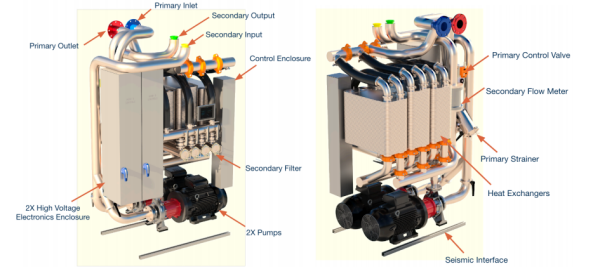

Google自研CDU

在机架与数据中心层面,Google 自研的模块化冷却液分配单元(mCDU)通过泵与液-液热交换器将 IT 回路与设施冷却回路隔离,确保液体清洁可控、系统冗余可靠。第五代 CDU 可支持单机 2MW 散热,并通过多块并联液-液换热器与无密封高性能泵,实现超高流量、超低温差,同时兼容风冷与液冷混合场景。Google 将这一液冷心脏级方案开源至 OCP 社区,为行业提供超高功率密度数据中心的参考标准。

整体来看,Google 的液冷策略已不再仅是去除芯片热量,而是深度嵌入到 TPU 设计、服务器板卡、机架及数据中心基础设施的协同体系中。通过冷板与 CDU 的高度整合,液冷直接提升算力密度、降低能耗、提高系统可靠性,并释放数据中心的设计空间,支撑超大规模 AI 模型的训练与推理。随着 TPU 在 AI 推理场景中逐步对 GPU 发起挑战,液冷已成为 Google 高性能计算基础设施的核心竞争力,也是未来高功率数据中心建设不可或缺的基础设施能力。

04

最后

随着Alphabet加速布局Intersect能源与数据中心基础设施,以及 Google 自研 TPU 与液冷技术的快速迭代,高算力 AI 平台的建设正在迎来前所未有的速度与规模。液冷不再只是散热手段,而成为提升算力密度、优化能效与保障系统可靠性的核心基础设施,支撑未来大规模 AI 模型的训练与推理。此次并购与技术升级,将进一步强化 Google 在 AI 数据中心和能源创新领域的领先地位。