Supermicro 推出全新 4U和2-OU 液冷 NVIDIA HGX B300产品

来源 | DCD

[洞见热管理]获悉,2025年12月9日——Supermicro宣布其NVIDIA Blackwell架构产品线的扩展,推出了全新的4U和2-OU(OCP)液冷NVIDIA HGX B300系统并可发货。这些最新产品是Supermicro数据中心构建模块解决方案(DCBBS)的关键组成部分,为超大规模数据中心和AI工厂部署提供前所未有的GPU密度和能效。

推出4U和2-OU(OCP)液冷NVIDIA HGX B300系统,用于高密度超大规模和AI工厂部署,分别由Supermicro数据中心构建模块解决方案支持,支持DLC-2和DLC技术®

4U 液冷 NVIDIA HGX B300 系统,设计用于标准 19 英寸 EIA 机架,每机架最多可搭载 64 个 GPU,通过 DLC-2(直接液冷)技术捕捉高达 98% 的系统热量 紧凑且节能的2-OU(OCP)NVIDIA HGX B300 8-GPU系统,设计为21英寸OCP Open Rack V3(ORV3)规格,单机架最多可支持144块GPU

Supermicro总裁兼首席执行官梁查尔表示:“随着全球AI基础设施需求的加速,我们的新型液冷NVIDIA HGX B300系统为超大规模企业和AI工厂提供了当前所需的性能密度和能效。”“我们现在提供业界最紧凑的NVIDIA HGX B300解决方案——单机架可实现多达144个GPU——同时通过经过验证的直接液冷技术降低功耗和散热成本。通过我们的DCBBS,Supermicro帮助客户大规模部署人工智能:更快上市时间、每瓦性能最大化,以及从设计到部署的端到端集成。”

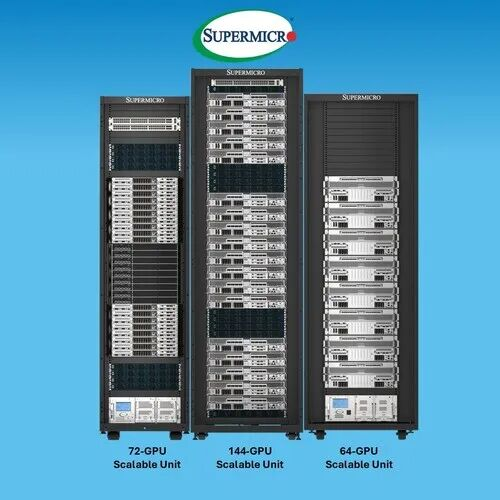

2-OU(OCP)液冷NVIDIA HGX B300系统,采用21英寸OCP Open Rack V3(ORV3)规格,每机架最多支持144枚GPU,为需要空间高效机架的超大规模和云服务提供商提供最大GPU密度,同时不影响可用性。机架级设计采用盲接歧管连接、模块化GPU/CPU托盘架构以及最先进的组件液冷解决方案。该系统通过八块NVIDIA Blackwell Ultra GPU支持AI工作负载,每块最高可达1100W TDP,同时大幅降低机架占地面积和功耗。单个ORV3机架最多支持18个节点,总共144个GPU,并可无缝与NVIDIA Quantum-X800 InfiniBand交换机和Supermicro的1.8MW行列冷却液分配单元(CDU)无缝扩展。八个NVIDIA HGX B300计算机架、三个NVIDIA Quantum-X800 InfiniBand网络机架和两个Supermicro列式CDU组成了一个拥有1,152个GPU的SuperCluster可扩展单元。

作为2-OU(OCP)模型的补充,4U前置输入输出HGX B300液冷系统在传统19英寸EIA机架形态下,为大规模AI工厂部署提供相同的计算性能。4U系统利用Supermicro的DLC-2技术,捕捉高达98%的热量通过液冷实现了卓越的能效,降低噪声,并提高高可用性,适用于密集训练和推理集群。

Supermicro NVIDIA HGX B300 系统实现了显著的性能提升,每台配备 2.1TB HBM3e GPU 内存,以应对系统层面更大的型号尺寸。最重要的是,2-OU(OCP)和4U平台在集群层面显著提升性能,通过集成的NVIDIA ConnectX-8超级网卡,将计算结构网络吞吐量翻倍至800Gb/s,配合NVIDIA Quantum-X800 InfiniBand或NVIDIA Spectrum-4以太网。这些改进加速了人工智能工厂中如代理型AI应用、基础模型训练和多模态大规模推理等重型AI工作负载。

Supermicro开发这些平台以满足客户在TCO、可维修性和效率方面的关键需求。通过DLC-2技术栈,数据中心可实现高达40%的节能通过45°C温水作减少用水量,并消除数据中心的冷水和压缩机。Supermicro DCBBS将新系统作为经过充分验证和测试的机架,作为L11和L12解决方案,在发货前完成,加快超大规模、企业和联邦客户的上线时间。这些新系统扩展了Supermicro广泛的NVIDIA Blackwell平台组合——包括NVIDIA GB300 NVL72、NVIDIA HGX B200和NVIDIA RTX PRO 6000 Blackwell服务器版。这些来自Supermicro的NVIDIA认证系统均经过测试,以验证其在多种AI应用和用例中的最佳性能——包括NVIDIA网络和NVIDIA AI软件,包括NVIDIA AI Enterprise和NVIDIA Runbin。这为客户提供了构建从单节点扩展到全栈AI工厂的AI基础设施的灵活性。